Gli esperti chiedono di fermare l'ulteriore sviluppo dell'intelligenza artificiale. Cosa li spinge a farlo?

L'intelligenza artificiale sta vivendo un grande boom negli ultimi tempi. Tutti sono così entusiasti di questa tecnologia da non rendersi conto dei rischi che potrebbe comportare in futuro. Gli esperti di IA stanno attualmente lanciando l'allarme, avvertendo che le aziende dovrebbero iniziare ad affrontare i rischi prima che sia troppo tardi.

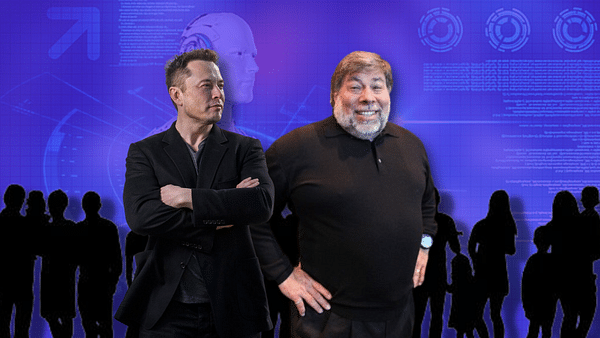

In una recente lettera aperta intitolata "Pause Giant AI Experiments: An Open Letter", gli esperti di intelligenza artificiale (AI) invitano le aziende che operano nel settore a interrompere temporaneamente lo sviluppo di sistemi di AI generativa. La lettera, firmata da oltre 1.000 persone tra cui Elon Musk, Steve Wozniak, Evan Sharp, Craig Peters e Yoshua Bengio, sottolinea l'incertezza sul potenziale impatto futuro dei risultati di questi sviluppi.

Nella lettera, gli esperti suggeriscono una pausa di sei mesi per sviluppare politiche e procedure normative per far progredire in sicurezza la tecnologia dell'IA. La pausa dovrebbe riguardare solo l'addestramento di sistemi di IA più potenti del GPT-4, il modello di IA generativa sviluppato da OpenAI. Se l'appello degli esperti non verrà ascoltato, la lettera suggerisce ai governi di imporre una moratoria.

Tra le aziende che investono nello sviluppo dell'IA generativa e delle tecnologie correlate ci sono colossi come Microsoft $MSFT, Alphabet $GOOGL, Alibaba $BABA e Baidu $BIDU. La lettera degli esperti chiede protocolli di sicurezza e la garanzia di un impatto positivo e della gestione del rischio. L'esito della lettera potrebbe indurre le aziende a fermarsi e a formulare nuove politiche o almeno a riflettere sui potenziali impatti e ad adottare le misure necessarie.

Il GPT-4 come fattore scatenante di potenziali problemi

Il GPT-4, introdotto di recente, ha impressionato gli utenti per le sue capacità di conversazione, scrittura di canzoni e riassunto di lunghi documenti. La reazione a questo modello ha spinto concorrenti come Alphabet Inc. ad accelerare lo sviluppo di modelli linguistici simili di grandi dimensioni. Tuttavia, gli esperti di IA chiedono un rallentamento dello sviluppo fino a quando non avremo compreso meglio le implicazioni e i potenziali danni per la società.

Il Future of Life Institute, un'organizzazione senza scopo di lucro finanziata principalmente dalla Musk Foundation, dal gruppo londinese Founders Pledge e dalla Silicon Valley Community Foundation, che ha pubblicato una lettera aperta, ritiene che i potenti sistemi di IA dovrebbero essere sviluppati solo quando siamo sicuri che i loro effetti saranno positivi e i loro rischi gestibili. L'organizzazione chiede inoltre che venga istituito un organismo di regolamentazione per garantire che lo sviluppo dell'IA serva l'interesse pubblico.

Elon Musk, cofondatore di OpenAI e uno degli esperti che hanno firmato la lettera, è noto per i suoi avvertimenti sui potenziali rischi associati allo sviluppo dell'IA. Afferma che è essenziale stabilire protocolli di sicurezza condivisi, sviluppati da esperti indipendenti, ed esorta gli sviluppatori a lavorare con i politici sulla governance.

Il direttore esecutivo di OpenAI, Sam Altman, e i CEO di Alphabet e Microsoft, Sundar Pichai e Satya Nadella, non erano tra i firmatari della lettera aperta. Tuttavia, la lettera rappresenta un passo importante verso l'apertura di una discussione sul futuro dell'IA e sui potenziali rischi che essa comporta.

Possibili implicazioni della lettera

La lettera può avere diverse implicazioni. Una è che le aziende e gli istituti di ricerca coinvolti nello sviluppo dell'IA potrebbero interrompere temporaneamente le loro attività e ripensare le loro pratiche. Questo scenario consentirebbe agli esperti e alle autorità di regolamentazione di esaminare gli sviluppi finora registrati e di adottare le misure necessarie per garantire la sicurezza e la sostenibilità nel campo dell'IA.

In alternativa, la lettera potrebbe portare a una maggiore consapevolezza dei potenziali rischi associati allo sviluppo dell'IA e alla necessità di stabilire protocolli di sicurezza e procedure normative. Ciò consentirebbe alle aziende di concentrarsi maggiormente sulla creazione di sistemi di IA più sicuri ed etici che abbiano un impatto positivo sulla società.

Infine, la lettera potrebbe ispirare i governi e le organizzazioni internazionali a prendere in considerazione l'introduzione di misure normative e moratorie per lo sviluppo dell'IA. Ciò garantirebbe che lo sviluppo dell'IA sia condotto nel rispetto dei migliori interessi della società e gestito in modo da ridurre al minimo i potenziali impatti negativi.

A prescindere dall'esito della lettera aperta, è chiaro che il dibattito sulla sicurezza e sull'etica dello sviluppo dell'IA è sempre più urgente. Poiché i sistemi di IA come il GPT-4 diventano sempre più pervasivi nella vita quotidiana, è necessario concentrarsi su come queste tecnologie possano essere utilizzate per il bene della società senza compromettere la privacy, la sicurezza o gli interessi degli individui.

Un esempio che dimostra come i sistemi di IA possano essere utilizzati per il bene pubblico è l'uso delle GPT-4 per risolvere problemi ambientali, sanitari o economici. D'altro canto, è importante considerare i possibili rischi, come l'uso improprio della tecnologia per diffondere disinformazione, manipolare l'opinione pubblica o aumentare le disuguaglianze nell'accesso alla tecnologia.

La lettera aperta "Pause Giant AI Experiments" è un invito a riflettere sulla strada che prenderà lo sviluppo dell'IA. Resta da vedere se sarà possibile raggiungere un consenso tra esperti, aziende e governi. Tuttavia, è importante che gli scienziati, i leader dell'industria e i responsabili politici si concentrino sulla collaborazione per trovare il modo di garantire e regolamentare lo sviluppo dell'IA nell'interesse dell'umanità.

AVVERTENZA: non sono un consulente finanziario e questo materiale non costituisce una raccomandazione finanziaria o di investimento. Il contenuto di questo materiale è puramente informativo.